機器學(xué)習(xí)中的加權(quán)采樣算法 理論與軟件開發(fā)實踐

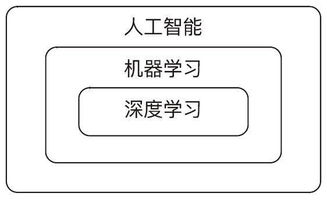

在人工智能的快速發(fā)展浪潮中,機器學(xué)習(xí)算法作為其核心驅(qū)動力,正不斷推動著技術(shù)的邊界。其中,加權(quán)采樣算法作為一種基礎(chǔ)且強大的數(shù)據(jù)處理工具,在模型訓(xùn)練、數(shù)據(jù)預(yù)處理、強化學(xué)習(xí)及推薦系統(tǒng)等多個關(guān)鍵領(lǐng)域扮演著不可或缺的角色。本文旨在深入探討加權(quán)采樣算法的理論基礎(chǔ),并闡述其在算法軟件開發(fā)中的實踐應(yīng)用。

一、加權(quán)采樣算法的理論基礎(chǔ)

加權(quán)采樣,顧名思義,是指從一組樣本中按照預(yù)設(shè)的權(quán)重分布進(jìn)行隨機抽取的過程。與簡單隨機抽樣不同,加權(quán)采樣允許某些樣本以更高的概率被選中,這直接反映了樣本在特定任務(wù)中的重要性差異。其數(shù)學(xué)核心在于構(gòu)建一個與權(quán)重成正比的概率分布。

常見的加權(quán)采樣算法包括:

- 輪盤賭選擇法:這是最直觀的算法。其原理是將所有權(quán)重歸一化后累加,形成一個“輪盤”,每個樣本占據(jù)與其權(quán)重成比例的一段弧長。然后生成一個[0,1)區(qū)間的隨機數(shù),該隨機數(shù)落在哪段弧長區(qū)間內(nèi),就選中對應(yīng)的樣本。該方法實現(xiàn)簡單,但每次采樣都需要O(N)的時間復(fù)雜度(N為樣本總數(shù))。

- 別名方法:這是一種高效的O(1)時間復(fù)雜度采樣算法。其核心思想是通過巧妙的預(yù)處理,將非均勻的加權(quán)分布轉(zhuǎn)化為一個由若干個“二元項”組成的均勻混合分布。每個二元項包含至多兩個樣本及其被選中的條件概率。預(yù)處理步驟需要O(N)時間,但之后的每次采樣僅需生成兩個隨機數(shù)并進(jìn)行一次比較,速度極快,尤其適合大規(guī)模、高頻次的采樣場景。

- 樹形結(jié)構(gòu)采樣法:例如使用二叉堆或Fenwick樹(樹狀數(shù)組)來存儲累積權(quán)重。這種方法支持在O(log N)時間內(nèi)完成單次采樣,并且其優(yōu)勢在于能夠高效地支持動態(tài)更新權(quán)重(即在線學(xué)習(xí)場景中權(quán)重的實時變化),而別名方法在權(quán)重更新后通常需要重新進(jìn)行O(N)的預(yù)處理。

加權(quán)采樣的理論意義在于,它為解決類別不平衡、強化學(xué)習(xí)中的優(yōu)先級經(jīng)驗回放、蒙特卡洛方法中的重要性采樣以及集成學(xué)習(xí)中樣本的權(quán)重分配等問題提供了數(shù)學(xué)框架。

二、算法軟件開發(fā)中的實踐要點

將加權(quán)采樣理論轉(zhuǎn)化為穩(wěn)定、高效的軟件模塊,是人工智能系統(tǒng)工程化的重要一環(huán)。在軟件開發(fā)實踐中,需關(guān)注以下幾個核心方面:

- 算法選擇與場景匹配:開發(fā)之初,必須根據(jù)應(yīng)用場景的具體需求選擇最合適的算法。例如,在離線批量處理、權(quán)重固定的場景(如數(shù)據(jù)集的初始重采樣),別名方法是性能最佳選擇。而在強化學(xué)習(xí)的經(jīng)驗回放池中,樣本的優(yōu)先級(權(quán)重)會隨著學(xué)習(xí)過程不斷更新,此時支持動態(tài)權(quán)重高效更新的樹形結(jié)構(gòu)方法(如SumTree)則更為合適。

- 數(shù)值穩(wěn)定性:權(quán)重值可能來源于模型輸出的概率(如Softmax結(jié)果),可能非常小或差異極大。直接計算可能導(dǎo)致下溢或精度損失。在軟件實現(xiàn)中,通常需要對權(quán)重進(jìn)行適當(dāng)?shù)臄?shù)值處理,例如取對數(shù)進(jìn)行操作,或在累加前進(jìn)行縮放,以確保計算的魯棒性。

- 高性能實現(xiàn):對于核心采樣函數(shù),應(yīng)追求極致的性能。這包括:

- 利用向量化計算:在Python中,優(yōu)先使用NumPy等庫的向量化操作替代循環(huán),以利用底層C/Fortran代碼的速度和硬件并行能力。

- 內(nèi)存布局優(yōu)化:確保數(shù)據(jù)在內(nèi)存中連續(xù)存儲,以提高緩存命中率。

- 并行化設(shè)計:對于需要獨立進(jìn)行大量采樣的任務(wù),可以設(shè)計并行采樣接口,充分利用多核CPU資源。

- API設(shè)計與易用性:一個好的加權(quán)采樣模塊應(yīng)提供清晰、簡潔的應(yīng)用程序接口。典型的接口可能包括:

initialize(weights): 初始化采樣器,接受權(quán)重數(shù)組。

sample(size=1, replace=True): 執(zhí)行采樣,返回樣本索引。參數(shù)控制采樣數(shù)量和是否放回。

update<em>weight(index, new</em>weight): (如果算法支持)更新指定樣本的權(quán)重。

- 提供同時返回樣本索引和對應(yīng)歸一化概率的選項,以便于后續(xù)計算(如重要性采樣中的比率校正)。

- 測試與驗證:必須對采樣器進(jìn)行嚴(yán)格的測試。這包括:

- 正確性驗證:通過進(jìn)行數(shù)百萬次采樣,統(tǒng)計各樣本被選中的頻率,并與理論概率分布進(jìn)行對比(如使用卡方檢驗),以確保采樣偏差在可接受的統(tǒng)計誤差范圍內(nèi)。

- 性能基準(zhǔn)測試:在不同數(shù)據(jù)規(guī)模(N)下,對采樣速度進(jìn)行 profiling,確保其符合算法預(yù)期的理論時間復(fù)雜度。

- 邊緣情況處理:測試所有權(quán)重為零、部分權(quán)重為負(fù)或無窮大等異常輸入時的魯棒性。

三、應(yīng)用實例

在機器學(xué)習(xí)系統(tǒng)開發(fā)中,加權(quán)采樣模塊被廣泛集成:

- XGBoost/LightGBM:在構(gòu)建每棵決策樹時,會對訓(xùn)練樣本進(jìn)行加權(quán)采樣(Bootstrap),權(quán)重可能由前一輪迭代的預(yù)測誤差決定。

- 深度強化學(xué)習(xí)(如DQN, SAC):在經(jīng)驗回放中使用優(yōu)先級采樣,使智能體更頻繁地從那些“意想不到”或“高學(xué)習(xí)價值”的過往經(jīng)驗中學(xué)習(xí),加速收斂。

- 類別不平衡分類:在訓(xùn)練神經(jīng)網(wǎng)絡(luò)前,對訓(xùn)練批次進(jìn)行加權(quán)采樣,增加少數(shù)類樣本的出現(xiàn)概率,以緩解模型對多數(shù)類的偏見。

###

加權(quán)采樣算法是連接機器學(xué)習(xí)理論與高效工程實踐的橋梁之一。深入理解其數(shù)學(xué)原理,并結(jié)合現(xiàn)代軟件工程的最佳實踐進(jìn)行開發(fā),能夠為復(fù)雜的人工智能系統(tǒng)提供可靠、高效的基礎(chǔ)數(shù)據(jù)操作組件。隨著機器學(xué)習(xí)模型和應(yīng)用的日益復(fù)雜,對采樣算法的性能、靈活性及正確性提出了更高要求,這將繼續(xù)推動該領(lǐng)域算法與軟件實現(xiàn)的雙重創(chuàng)新。

如若轉(zhuǎn)載,請注明出處:http://www.atb393.cn/product/64.html

更新時間:2026-01-22 15:39:08